Mostrando postagens com marcador Inteligência artificial. Mostrar todas as postagens

Mostrando postagens com marcador Inteligência artificial. Mostrar todas as postagens

quarta-feira, 29 de agosto de 2018

A inteligência artificial chega ao mundo das artes

Quando o assunto é futuro do trabalho, muitos estudos debatem como o desenvolvimento de algoritmos de inteligência artificial mais capazes vai colocar em risco milhões de empregos. Esses mesmos estudos apontam as profissões que têm mais ou menos chances de serem eliminadas, e aquelas cujas atividades envolvem criatividade e imaginação geralmente são citadas como imunes à automação. Porém essa imunidade pode estar com os dias contados.

Em outubro, a Christie’s, uma das mais famosas casas de leilão de artes do mundo, fundada em 1766, vai, pela primeira vez, leiloar um quadro criado inteiramente por inteligência artificial, em sua filial de Nova York. A peça, intitulada “Edmond de Belamy”, é o retrato de uma pessoa (que, aliás, nunca existiu) e foi feita por um algoritmo desenvolvido pela startup francesa Obvious, cujo lema é “Criatividade não é só para humanos”.

Para conseguir gerar as imagens, a Obvious utilizou uma técnica conhecida como GAN (acrônimo para generative adversarial network ou, em português, rede geradora adversária). Para entender melhor como ela funciona, conversei com Saulo Catharino, consultor em aprendizado de máquinas e diretor da empresa Bitrental.

O GAN é formado por duas redes neurais, uma conhecida como geradora e outra como discriminadora. Nesse caso dos quadros, a geradora foi ensinada a fazer desenhos aleatórios, tendo como base algumas especificações (por exemplo, como são retratos, eles precisam ter dois olhos, um nariz...). Já a discriminadora foi alimentada com uma imensa base de dados de 15 mil pinturas de retratos existentes dos séculos 14 a 20. Assim, conforme a geradora ia desenhando, a discriminadora media se esses desenhos se aproximavam daqueles da base de dados ou não. Com esse feedback, a geradora foi melhorando seu desempenho, até que conseguiu criar imagens similares, chegando ao resultado final. O uso dessa técnica faz com que os responsáveis pela Obvious se refiram às suas obras como parte de um novo movimento artístico, o “GAN-ismo”.

A empresa francesa não é a única a apostar em inteligência artificial criativa. Na Universidade de Rutgers, nos EUA, pesquisadores desenvolveram um algoritmo que consegue gerar cerca de mil imagens originais a cada vez que é acionado. E para testar esses trabalhos, colocaram-nos ao lado de outras obras criadas por humanos em um site onde pessoas puderam avaliá-los em termos de complexidade e inspiração. E alguns dos que foram produzidos pelo algoritmo tiveram uma avaliação superior.

Além de imagens, outras formas de expressão artística também estão sendo desenvolvidas por inteligência artificial: alguns algoritmos conseguem criar poemas “inspirados” em fotos (apesar de que o resultado nem sempre é dos melhores) e se aventurar no mundo da música. Ano passado, a cantora americana Taryn Southern lançou um álbum inteiro produzido por IA. E, em 2016, aqui no Brasil, o Spotify, em parceria com a empresa Kunumi, de Belo Horizonte, e o grupo de rap RZO, lançou uma música do rapper Sabotage, morto em 2003. Para isso, alimentou uma rede neural com diversas composições e manuscritos do artista. Com essa base, o algoritmo desenvolveu uma letra inspirada no estilo de Sabotage. A canção, aliás, chama-se “Neural”.

No entanto, essas iniciativas provocaram uma discussão: afinal, quadros, músicas ou outras obras criadas por inteligência artificial podem ser chamados de arte? A resposta é a mais em cima do muro possível: depende. Se avaliados apenas pelo aspecto estético, sim. Porém, se definirmos arte como uma forma de expressão de sentimentos, sensibilidade e personalidade de quem cria, fica complicado classificar inteligência artificial como artista, pois não existem (pelo menos ainda) algoritmos com essa capacidade.

Seja como for, o “Edmond de Belamy” irá a leilão em outubro, com preço estimado na casa dos US$ 10 mil. E você, faria um lance por essa obra?

Jornal do Brasil

domingo, 24 de junho de 2018

quarta-feira, 16 de maio de 2018

Como a inteligência artificial está ajudando a decifrar os códigos do Arquivo Secreto do Vaticano

Um novo software pode fazer com que séculos de documentos escritos em latim sejam disponibilizados na internet

Zelda Caldwell | Ateteia

O Archivum Secretum Vaticanum ou Arquivo Secreto do Vaticano (ASV) parece algo tirado das teorias conspiratórias de ficção, bem ao estilo do escritor Dan Brown.

Mas, na realidade, os ASV são simplesmente um conjunto de arquivos privados (melhor tradução para a palavra “secretum”) do Papa. Porém, desde que o Papa Leão XIII abriu o arquivo a alguns estudiosos, em 1881, ele deixou de ser particular.

Teoricamente, desde o século VIII, todos os textos, documentos históricos, atas promulgadas pelo Vaticano, livros de contas e correspondências dos papas estão disponíveis aos pesquisadores qualificados para isso.

O único problema é que o enorme volume de arquivos os torna virtualmente inacessíveis.

De acordo com um artigo de Sam Kean publicado no The Atlantic, dos 85 quilômetros de fila de estantes do Arquivo Secreto do Vaticano, somente poucos milímetros de páginas foram escaneados, transcritos e preparados para ficarem acessíveis aos serviços de busca na internet.

Agora, o In Codice Ratio, um programa que utiliza inteligência artificial e reconhecimento ótico de caracteres (OCR) para transcrever automaticamente conteúdos, está sendo utilizado para digitalizar os arquivos do Vaticano.

Porém, segundo Kean, o OCR faz maravilhas com documentos escritos à máquina, mas não pode processar o texto manuscrito. As letras tendem a se misturar e nem sempre o que se encontram são “exemplos claros e nítidos” das letras que supostamente representam.

É aí que entra em jogo a inteligência artificial. Os pesquisadores recrutaram estudantes de um instituto italiano sem nenhum conhecimento em latim medieval. Com base em exemplos de letras que o software de OCR já havia identificado, os estudantes deveriam comprovar se elas correspondiam ou não aos símbolos corretos. Tudo o que eles tinham que fazer era comprovar os padrões visuais. O software anotou os apontamentos que os estudantes fizeram e corrigiu os erros.

Quando o projeto teve início, “a ideia de envolver os estudantes era desacreditada”, contou Paolo Merialdo, cientista da Codice Ratio. “Mas, agora, a máquina está aprendendo com os esforços dos estudantes. É incrível como uma pequena e simples contribuição de muitas pessoas pode ajudar a solucionar um problema tão complexo”, comemora Paolo.

Transcrever ao computador os antigos escritos também não está sendo tarefa simples. Um terço das palavras continha erros, o que atrapalhava a leitura. Mas o trabalho já foi considerado um grande avanço.

“As transcrições imperfeitas podem oferecer informações suficientes sobre o contexto do manuscrito em questão”, contou Merialdo a Kean.

Além disso, os cientistas que estão por trás do projeto esperam que o software melhore com o tempo, já que, quanto mais se aprende com a inteligência artificial, melhores são os resultados obtidos.

Para ler o artigo completo do The Atlantic (em inglês), clique aqui.

quarta-feira, 18 de abril de 2018

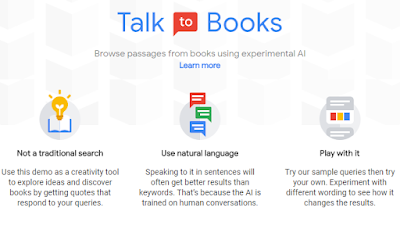

Cientista da vida eterna cria buscador que responde a questões profundas com base em livros

“Como eu faço para parar de pensar e conseguir dormir?” é uma das perguntas que o novo mecanismo de busca semântica se propõe a responder com base em mais de 120 mil livros

Gazeta do Povo

Um novo tipo de busca online chega ao universo do Google graças às pesquisas de linguística do futurologista Ray Kurzweil, cientista da computação e autor de livros influentes sobre inteligência artificial. Ele também é famoso pela crença no prolongamento eterno da vida, o que o leva a tomar cem pílulas por dia.

“Como eu faço para parar de pensar e conseguir dormir?”, escreveu Kurzweil no Talk to Books, num teste ao vivo para a audiência do TED, evento de palestras que aconteceu em Vancouver na semana passada.

Os resultados aparecem em negrito em trechos de livros, com seus títulos e páginas, e Kurzweil acredita que poderiam ser usados como respostas naturais numa conversa. O cientista, que trabalha com uma equipe de 40 engenheiros, disse que usou bilhões de linhas de diálogo para ensinar o software de inteligência artificial como funciona uma conversa real.

Apesar de os resultados para algumas perguntas mais práticas não serem muito diferentes do que uma busca tradicional (em vez de sites, leva para livros), tal tecnologia já vem sendo aplicada em produtos do Google.

No Gmail, por exemplo, os usuários ganharam opções de respostas curtas automáticas ao final de cada e-mail.

Níveis humanos

Kurzweil acredita que máquinas com inteligência artificial (IA) chegarão a níveis humanos por volta de 2029. “Todos nós vamos virar predominantemente IA. Já somos bem misturados, nunca saímos de casa sem nossos IAs”, disse, referindo-se a celulares. “E eles serão muito mais intimamente integrados com a gente daqui para frente.”

E não só: essas máquinas terão consciência. “Debatemos hoje sobre consciência dos animais. E vamos debater isto sobre IA também [...] Nós vamos querer acreditar que eles têm consciência porque serão tão espertos e vão ficar bravos se duvidarmos.”

Durante o TED, o autor de A Singularidade Está Próxima (2005) lançou o livro ilustrado Danielle, mistura de ficção com não ficção, sobre uma jovem heroína que resolve desafios do mundo com tecnologias avançadas, como problema de água na África ou cura do câncer.

“Não existe problema que não possa ser resolvido com inteligência coletiva e tecnologia que temos hoje”, falou.

Kurzweil, 70, também comentou sobre suas ideias de “extensão radical da vida”. Além das iniciativas que podem ser tomadas agora, como as cem pílulas que ele ingere por dia (em 2005, eram 250), o cientista acredita na biotecnologia e reprogramação genética.

“Uma outra fase seria a aplicação de nanotecnologia para estender seu sistema imunológico. Há cenários de acabar com todas as doenças e processos de envelhecimento”, disse. “Vai acontecer no mundo desenvolvido em uma década. E acho que estarei lá. Mas, claro, você sempre pode ser atingido por um ônibus amanhã.”

quinta-feira, 22 de março de 2018

Inteligência Artificial não transforma o profissional em um inútil

A inteligência artificial está cada vez mais presente no nosso dia a dia e já interfere diretamente no mercado de trabalho. E o professor especializado em neurociência e inteligência artificial Nelson Gonçalves, da FGV, destaca que não há nenhum problema em profissões serem substituídas pela tecnologia.

“A tecnologia sempre destruiu empregos. No caderno de empregos do jornal de 1972 os empregadores procuravam kardexista. Era um trabalho com um método de controle de estoque, baseado em uma planilha escrita à mão. Esse emprego foi varrido [pela tecnologia]. Ainda bem. Esse profissional foi fazer outra coisa”, disse Gonçalves durante o evento Data Driven, organizado pela empresa Neoway, especializada em big data, de acordo com reportagem do portal Info Money.

“É evidente que a tecnologia varre empregos, e sempre varreu, desde a revolução industrial. Não estamos diante de nenhum processo novo. Então essa apocalíptica de falar que a IA vai te desempregar, e te transformar em uma pessoa inútil, não faz sentido”, continuou o professor da FGV.

Ele listou algumas profissões que devem desaparecer, em algum momento, por conta do avanço da tecnologia e da inteligência artificial. “Olhando para frente e fazendo um exercício sério, dá para dizer que essas profissões vão ser ‘varridas’ pela inteligência artificial. Ou pelo menos o mercado de trabalho vai ficar muito mais restrito do que ele é hoje”, completou.

segunda-feira, 5 de março de 2018

Inteligência artificial vai mudar todos os relacionamentos humanos

Para historiador, Google, Facebook e Amazon competem em revolução digital e redes sociais ficam arcaicas

O historiador Andrew Keen, durante debate da União Europeia - Mélanie Wenger/ DLD

Folha - Seus livros e artigos são um alerta sobre os perigos da internet há uma década. Como vê a rede mundial hoje?

Andrew Keen - Tenho uma visão histórica sobre a revolução digital e a vejo como outras grandes mudanças tecnológicas e culturais do passado, como a Revolução Industrial e a Reforma Protestante, mas já não gosto mais de usar essa palavra internet.

A internet está em todos os lugares hoje em dia e provocou uma mudança profunda na forma como aprendemos, conversamos e administramos governos e os negócios.

É uma mudança tão forte quanto a Revolução Industrial, com a diferença que já não há crianças trabalhando em fábricas que cospem fumaça nem o surgimento de uma nova classe proletária.

Em vez disso, as empresas de tecnologia se tornaram as mais ricas e poderosas do planeta e estão todas concentradas na costa oeste dos Estados Unidos. Isso gerou outros níveis de riqueza e figuras como Jeff Bezos, o dono da Amazon que é talvez o homem mais rico da história.

Os humanos podem se tornar obsoletos no futuro próximo?

Não penso isso, mas precisamos entender o que está acontecendo e desenvolver novas formas de agir. Na era das máquinas inteligentes e dos algoritmos, precisamos entender o que só os humanos ainda conseguem fazer.

Leia a entrevista completa na Folha de S. Paulo

O historiador Andrew Keen, durante debate da União Europeia - Mélanie Wenger/ DLD

Folha - Seus livros e artigos são um alerta sobre os perigos da internet há uma década. Como vê a rede mundial hoje?

Andrew Keen - Tenho uma visão histórica sobre a revolução digital e a vejo como outras grandes mudanças tecnológicas e culturais do passado, como a Revolução Industrial e a Reforma Protestante, mas já não gosto mais de usar essa palavra internet.

A internet está em todos os lugares hoje em dia e provocou uma mudança profunda na forma como aprendemos, conversamos e administramos governos e os negócios.

É uma mudança tão forte quanto a Revolução Industrial, com a diferença que já não há crianças trabalhando em fábricas que cospem fumaça nem o surgimento de uma nova classe proletária.

Em vez disso, as empresas de tecnologia se tornaram as mais ricas e poderosas do planeta e estão todas concentradas na costa oeste dos Estados Unidos. Isso gerou outros níveis de riqueza e figuras como Jeff Bezos, o dono da Amazon que é talvez o homem mais rico da história.

Os humanos podem se tornar obsoletos no futuro próximo?

Não penso isso, mas precisamos entender o que está acontecendo e desenvolver novas formas de agir. Na era das máquinas inteligentes e dos algoritmos, precisamos entender o que só os humanos ainda conseguem fazer.

Leia a entrevista completa na Folha de S. Paulo

sexta-feira, 2 de fevereiro de 2018

Uma distopia digital

Não é à toa que muitos consideram dados equivalentes ao petróleo; para Morozov, no entanto, o novo petróleo não são os dados, mas a inteligência artificial.

Pedro Doria | O Estado de S. Paulo

Imagem: Internet (Evgeny Morozov)

Há uma nova teoria circulando a respeito de para onde a internet nos leva. Segundo esta leitura, algumas poucas empresas estão construindo sistemas de inteligência artificial que se tornarão rapidamente fundamentais para a vida. Todos os governos, organizações da sociedade civil e indústrias dependerão desta tecnologia. Que será controlada por um oligopólio. Estamos assistindo ao nascimento de monstros.

Sempre que alguém apresenta um cenário distópico assim, não custa dar uns passos atrás.

Para muitos no Vale do Silício, Evgeny Morozov é um neoludita. Alguém com medo irracional de tecnologia. Esta semana, a revista americana Politico o anunciou em sua lista de 28 pessoas que farão diferença em 2018.

Nascido na Bielorrússia, criado na Bulgária, morador de Barcelona - 33 anos. É escritor. Foi professor visitante em Stanford, a universidade no coração do Vale. Teve uma bolsa do Yahoo para estudar em Georgetown. TED Fellow. E está terminando o doutorado em Harvard. Não se trata do currículo típico de um ludita. Mas ele desconfia do Vale.

Na sua visão, por exemplo, o Grande Firewall da China não é apenas um instrumento de censura do governo. Tem também este papel.

Mas é, antes de tudo, um recurso protecionista. Impede a entrada de tecnologia americana no País do Centro, enquanto sua própria indústria se desenvolve. Esta semana, aliás, o governo americano intercedeu perante uma operadora de celular para que os aparelhos topo de linha da Huawei não sejam vendidos, pois são equivalentes a Motorola e Apple. A guerra pelo futuro da tecnologia entre os dois países está oficialmente aberta.

Morozov questiona a ideia, amplamente difundida, de que dados são, para o século 21, o que o petróleo foi para o século 20.

Dados alimentam os produtos tecnológicos e sustentam a indústria. A Amazon armazena e analisa todo nosso comportamento na loja virtual. A partir do conjunto de todos seus clientes, faz cálculo de preços, decide o que apresentar a cada indivíduo, define logística. O Google usa dados de motoristas para oferecer o melhor caminho pelo Waze, compreende nossas inúmeras escolhas em buscas para produzir resultados melhores. O Facebook, e seu já famoso algoritmo, é também este imenso banco de dados no qual cada reação ao que vemos é armazenada para tornar o serviço mais eficiente.

E dados, evidentemente, são usados para veicular publicidade.

Não é à toa, portanto, que muitos consideram dados equivalentes ao petróleo. Se guerras foram travadas para garantir o combustível que ergueu economias, hoje são dados que alimentam a nova economia. Para Morozov, no entanto, esta é uma ilusão.

O novo petróleo não são os dados, mas a inteligência artificial.

Na fase pela qual passamos, as grandes massas de dados estão ensinando complexos algoritmos de inteligência artificial. Sim, dados são cruciais. Porque é o big data, este grande volume, que permite aos sistemas avaliarem as muitas possibilidades de comportamento. É enxergando padrões se repetirem que sistemas de IA aprendem a prever.

E aí está o pulo do gato: a inteligência artificial está sendo treinada e sofisticada por empresas, como Amazon, Google, Facebook, Microsoft, IBM. Aos poucos, aplicações surgem. Para todas as indústrias: do varejo à saúde, da educação ao transporte, energia, mineração. Governo. Democracia. Publicidade. Tudo será muito mais eficiente com inteligência artificial. A um ponto tal que, quem não tiver, estará muito atrás. Serão poucos vencedores.

Daí: desigualdade. Na leitura de Evgeny Morozov está nascendo um novo oligopólio.

terça-feira, 11 de julho de 2017

Google financia agência de notícias que contará com jornalistas robôs

Não é segredo para ninguém que os robôs vão nos substituir em diversas tarefas, principalmente as que demandam menos especialização mas mesmo algumas que exigem um pouco mais de qualificação estão sendo automatizadas. Temos por exemplo o caso do IBM Watson, que substituiu diversos salarymen no Japão em suas funções de calcular pagamentos de seguradoras. Já empresas de entregas expressa da China estão se robotizando, com os autômatos cuidando de tarefas que o pequeno Ping era responsável no passado.

Uma área que muita gente defende que um robô jamais será capaz de se enfiar é o jornalismo, mas mesmo ele já foi infiltrado em 2015: a AP, junto com a Automated Insights apresentou uma inteligência artificial plenamente capaz de redigir informes econômicos, a área mais burocrática, maçante e engessada da imprensa. Tudo ali é puramente mecânico e o sistema especialista se saiu muito bem, analisando as flutuações de mercado e publicando postagens e informes bem precisos. Hoje a IA sequer depende de monitoramento.

Só que a Press Association do Reino Unido quer ir além: ela deseja de fato automatizar até mesmo as notícias menos elaboradas, aquelas publicadas por outlets menores, redações independentes e até mesmo… blogueiros. O projeto, chamado Reporters and Data and Robots ou simplesmente RADAR envolve um sistema especialista capaz de redigir cerca de 30 mil histórias por mês. E o programa é tão promissor que chamou a atenção do Google: este realizou um investimento de £ 622.000 (cerca de R$ 2,6 milhões em valores de hoje, 10/07/2017) no RADAR, de modo a torna-lo realidade.

A ideia da associação de imprensa estatal é fechar parcerias com publishers para que estes venham a utilizar os serviços do RADAR em notas de menor importância, do nível clássico dos informes dos estagiários do G1, Folha, Estado e etc. com a diferença que os robôs escrevem melhor. Isso não significa entretanto que os jornalistas vão perder seus empregos: segundo o editor-chefe da PA Peter Clifton, os tradicionais ainda serão vitais para a imprensa na forma de artigos e notícias embasados, com opinião e mais elaborados. A IA ficará encarregada de automatizar publicações de menor impacto e mais gerais como das colunas de saúde, emprego, segurança e outras que provém pouca variação e interação direta. Em suma o RADAR será o “foca” encarregado das piores matérias, os press releases, os “Caetano Veloso atravessa a rua” e etc.

A PA pretende colocar o RADAR em funcionamento em 2018, e este dependerá de uma base de dados aberta para gerar as notícias, este administrado por cinco pessoas que se encarregarão de alimenta-lo com informações vindas do governo, autoridades locais, serviços de saúde, instituições financeiras e outros; os robôs utilizarão Processamento de Linguagem Natural para redigir as matérias de modo que o resultado fique minimamente decente e fluído, e não algo saído do Google Tradutor.

via MeioBit

segunda-feira, 15 de maio de 2017

O algoritmo imoral

Não existe neutralidade técnica ou axiológica nas redes sociais e buscadores como pretendem. Os resultados são frequentemente manipulados

por Carlos Alves Muller | O Globo

Há dias, “The Australian”, um dos principais jornais da Austrália, publicou reportagem sobre um documento da filial do Facebook sobre como identificar adolescentes emocionalmente frágeis. A “metodologia” teria sido oferecida a anunciantes como ferramenta de marketing segmentado, procedimento passível de ser enquadrado criminalmente como abuso contra pessoa vulnerável.

O Facebook respondeu que “não oferece ferramentas para chegar a pessoas com base em seu estado emocional”, mas admitiu a existência de uma “análise, feita por pesquisador australiano com o objetivo de ajudar marqueteiros a entender como as pessoas se expressam no Facebook”.

Não é a primeira vez que o Facebook, como outras redes sociais e buscadores, recorre a chicanas para eximir-se de responsabilidade. Foi o que ocorreu com recentes casos de assassinato (de um idoso nos EUA, e de um bebê, na Tailândia) cujas imagens foram postadas ao vivo; com grupos de pedofilia no mesmo Facebook, como denunciado pela BBC, e com anúncios (inclusive públicos), exibidos em sites promotores de ódio e terrorismo. E é o caso da propagação em escala industrial de notícias falsas e fraudes nos dados de visualização de publicidade, com o uso de robôs.

O argumento para eximir-se de responsabilidade é tão falso quanto a “notícia”: “Marisa fotografada na Itália. Morte da mulher de Lula é mentira, Entenda!”, difundida pelo site “Pensa Brasil”, notória fonte de notícias falsas, como revelado pela “Folha de S.Paulo” em 19/2 último. Não por acaso, se você digitar “Pensa” no Google, como fiz em 07/5, a primeira opção oferecida pelo buscador é... “Pensa Brasil”.

Não há neutralidade técnica ou axiológica nas redes sociais e buscadores como pretendem. Os resultados são frequentemente manipulados.

São provas disso o processo contra o Google que tramita na União Europeia, evidenciando que sites de negócios do próprio buscador têm prioridade sobre os dos concorrentes, e as notícias falsas disseminadas pelo Facebook na campanha eleitoral americana.

O argumento também é falso porque alega que “é o algoritmo...”. Ocorre, assim, uma antropomorfização de um programa de computador, ao mesmo tempo transformado em força telúrica contra a qual os mortais nada podem. Já os humanos que o desenvolveram e tomam as decisões nas empresas perdem a humanidade, escravos de uma “inteligência artificial”.

Na verdade, algoritmos fazem o que foram programados para fazer. É possível criar parâmetros para que façam algumas “opções”, mas tão limitados que o algoritmo tanto ignora a pedofilia em certas imagens (exceto as muito explícitas) quanto censura foto de campanha de aleitamento materno porque associa seio à mostra a pornografia. Correções de casos como estes só acontecem quando cobradas por internautas.

O problema de fundo é que só humanos podem discernir o que algoritmos não detectam. Redes sociais e congêneres se negam a reconhecê-lo, pois isso implica admitir que são empresas de mídia e não plataformas (o que tem consequências, inclusive jurídicas), abala seu “modelo de negócio”, causando uma explosão de custos. É preciso gente para produzir e editar conteúdo, evitando que crimes sejam praticados e exibidos, para que o anúncio vá para o público desejado, e não para outro seguidor de canais criminosos. É preciso gente habilitada para fazer jornalismo conforme as boas práticas numa sociedade democrática. E é preciso gente educada e com senso crítico para entender a importância dessas diferenças e não aceitar o que o algoritmo imoral lhe oferece.

Carlos Alves Müller é jornalista e consultor da Associação Nacional de Jornais

quinta-feira, 23 de fevereiro de 2017

Crítica | Eis os Delírios do Mundo Conectado

Se verificarmos com cuidado a carreira de Werner Herzog em retrospecto, perceberemos que o cineasta alemão, apesar de ter se notabilizado com obras de ficção como Aguirre, a Cólera dos Deuses, O Enigma de Kaspar Hauser, Stroszek e Fitzcarraldo, é, fundamentalmente, um documentarista. Desde 1970, ele vem legando ao mundo suas fantásticas visões sobre os mais diversos assuntos que comentam a Humanidade de uma forma ou de outra, desde corajosos médicos que levam tratamento para regiões inóspitas da África, passando pela trágica biografia de um homem que passou sua vida em meio a ursos selvagens até um olhar sobre os primórdios do Homem a partir das pinturas rupestres na caverna de Chauvet.

Eis os Delírios do Mundo Conectado é sua visão lírica, mas preocupada sobre o quanto somos dependentes da tecnologia, mais especificamente da internet. Como o título original e o em português tentam dar a entender, o que vemos no documentário são quase que devaneios sobre o passado, presente e futuro da tecnologia, em uma visão que não condena, mas também não aplaude os vários acontecimentos desde o fatídico dia em que, em 1969, a primeira mensagem foi enviada de um computador a outro separados por 400 milhas de distância. Que mensagem foi essa? “Lo”, pois a intenção era escrever LOG, mas a “rede” caiu e “LO” virou um termo profético, já que é costumeiramente usado na inglesa na expressão lo and behold, que significa “e eis” (em um contexto de surpresa e estupefação) e que dá nome ao documentário.

Herzog, que também faz as vezes de narrador e entrevistador, dividiu seu longa em dez curtos capítulos, um sobre um assunto diferente dentro da proposta. Com isso, ele manipula aquilo que a Internet e a facilidade de acesso à informação acabou criando no inconsciente coletivo: nossa incapacidade em geral em lidar com narrativas longas. Ao quebrar sua história em 10 segmentos de poucos minutos, Herzog garante - ou espera fortemente - que nossa atenção não se perderá e sua mensagem será passada.

Por outro lado, os poucos minutos impedem que as questões ganhem qualquer tipo de desenvolvimento e profundidade. Novamente uma característica do tipo de informação que as pessoas normalmente procuram, bastando notar como é comum lermos apenas as manchetes de uma notícia (ou as estrelas em uma crítica como esta), mas creio que, aqui, Herzog tenha perdido a oportunidade de mergulhar em questões controversas como a cultura hacker, a circulação de imagens sem autorização do fotografado, os possíveis efeitos de um mundo repentinamente sem internet, o desenvolvimento da inteligência artificial dentre outras.

O que ele faz - e claramente foi de propósito - é jogar as questões. Ele se recusa a dar soluções ou a dar sua própria impressão sobre as matérias que seu documentário lida. É como aquele professor de faculdade que levanta a boa para seus alunos, então, discutirem entre si durante toda a aula. Sem dúvida é uma forma de se abordar matérias importantes e sem dúvida seu longa leva à discussões potencialmente interessantes, mas é como se Herzog tivesse feito um esforço sobre-humano para trazer os assuntos da maneira mais básica possível, quase que como um “assuntos quentes da Internet for dummies“.

Considerando o calibre do diretor, algo que é visto em suas magníficas composições nas entrevistas estáticas ao longo do filme, com especial destaque para o quadro surrealista que “pinta” com uma família que perdera uma das filhas em acidente automobilístico, ele talvez pudesse ter trazido algo mais detalhado para seu público. Quando ele começa cronologicamente com a origem da Internet, parece que ele fará algo de teor mais histórico, mas logo no capítulo seguinte ele pula para questões polêmicas (uma delas particularmente ininteligível sobre a arquitetura da internet na visão de um de seus pioneiros) e não para mais, em uma sucessão de assuntos conectados unicamente pela questão macro de seu documentário.

Não esperava, de forma alguma, um mergulho técnico em cada matéria, mas algo fosse um meio termo, um compromisso entre a matéria do Fantástico e a análise dedicada de uma série do Discovery Channel. Herzog tinha capacidade para isso, sem dúvida, mas decidiu trilhar um caminho que, se não chega a desapontar, pelo menos leva o espectador com senso crítico a coçar a cabeça em dúvida.

E de forma alguma, com isso, eu quero dizer que Eis os Delírios… é comparável a uma matéria do Fantástico, mas apenas que o diretor mirou baixo demais e acabou gerando uma obra de pouco valor intrínseco. Bastaria, por exemplo, que ele tratasse de metade dos assuntos no dobro do tempo para cada um. Ou se ele usasse algum tipo de linearidade no desenvolvimento histórico da internet, sem pulos quase que aleatórios. Ou mesmo se ele tornasse os comentários dos entrevistados menos utópicos e mais diretos, como é o caso da fascinante - mas curta - entrevista com a celebridade hacker Kevin Mitnick.

Eis os Delírios do Mundo Conectado é bem menos do que poderia ter sido, mas não deixa de ser entretenimento bem acabado e que pode levar a conversas interessantes se o espectador não tiver sua atenção desviada por tuíte de um amigo ou a mais nova atualização de status no Facebook de alguém que segue. Mas sobre o que mesmo estava falando?

Eis os Delírios do Mundo Conectado (Lo and Behold, Reveries of the Connected World, EUA - 2016)

Direção: Werner Herzog

Roteiro: Werner Herzog

Com: Lawrence Krauss, Kevin Mitnick, Elon Musk, Sebastian Thrun, Lucianne Walkowicz, Robert Kahn, Ted Nelson, Hilarie Cash, Christina Catsouras, Sam Curry, Leonard Kleinrock, Tom Mitchell

Duração: 98 min.

via Plano Crítico

sexta-feira, 22 de julho de 2016

Portal agrupa notícias e monitora Olimpíada nas redes

Depois do evento, a página vai servir como memória digital dos Jogos

Projeto ObservatóRio2016 cria gráficos interativos que permitem comparar temas e esportes mais citados

por Portal Brasil

O portal ObservatóRio2016, lançado pelo Instituto de Matemática Pura e Aplicada (Impa), permite aos internautas monitorar assuntos, imagens e notícias dos Jogos Olímpicos e Paralímpicos Rio 2016.

A partir dos dados coletados em redes sociais como o Instagram e, principalmente, o Twitter, o projeto cria gráficos interativos em que é possível visualizar e comparar os temas, esportes e hashtags mais populares.

Os comentários e notícias sobre os eventos foram agrupados de diferentes formas. Por meio do portal, é possível acessar o volume de menções às modalidades olímpicas; os países mais associados a determinados esportes; os tópicos mais citados diariamente desde 1º de maio; comparar as alusões positivas e negativas ao evento; e acompanhar o tour da tocha olímpica por meio de imagens publicadas nas redes sociais.

Segundo o coordenador do ObservatóRio2016, Luiz Velho, o projeto faz parte de uma pesquisa que envolve várias disciplinas como matemática, inteligência artificial, design e mídias. Ao final dos Jogos, o portal continuará no ar, servindo como uma memória digital do evento, que pode ser usada para consulta e, até mesmo, novas pesquisas.

"O portal vai ser como uma superbiblioteca do futuro. Essa pesquisa é uma maneira de contribuir com a sociedade para que ela veja a Olimpíada de uma forma diferente. Ao mesmo tempo, esse banco de dados vai ficar como um legado para o Brasil, o Rio de Janeiro e a Olimpíada em geral", afirma.

O projeto foi feito pelo laboratório Visgraf, que faz parte do Impa e promove pesquisas nas áreas de visão, computação gráfica e multimídia.

terça-feira, 21 de junho de 2016

Dados que curam

Na era digital, a possibilidade de coletar, organizar e acessar um mundo de informações favorece o trabalho dos médicos - e quem mais ganha são os pacientes

Por Raquel Beer | Veja

Schlesinger, da Mendelics: sequenciamento genético por 10 000 reais. Antes, custava mais que o dobro (Lailson Santos/Dados que curam)

“Declare o passado, diagnostique o presente e preveja o futuro”, dizia o fisiologista grego Hipócrates, apelidado de o pai da medicina, no século V a.C. Com essa elegante definição do trabalho médico, o pensador indicava a relevância do acúmulo de conhecimento prévio para guiar os tratamentos. Ao receber um paciente, o profissional de saúde precisa, antes de tudo, relacionar os sintomas relatados a outros quadros similares para realizar o exame, prescrever medicamentos e prever qual será a eficiência da terapia recomendada. Até muito recentemente, porém, antes do desenvolvimento de exames de laboratório complexos e conclusivos, os doutores tinham de confiar apenas na memória de um enfermo para desenhar um caminho de cura.

Deu-se agora uma espetacular guinada com o avanço da era digital, da inteligência alimentada pelos algoritmos e do big data — termo que descreve a possibilidade de organizar e consultar, de forma automática, montantes colossais de dados em qualquer área do conhecimento humano.

No século XXI, médicos dependem cada vez menos do próprio conhecimento, ou do que relatam os pacientes, para “declarar o passado, diagnosticar o presente e prever o futuro”. Bastam alguns cliques no computador para ter acesso a quase toda informação. Está acabando o tempo em que clínicos de pronto-socorro podem se contentar em dizer aos doentes, genericamente: “É uma virose”.

O impacto das novas tecnologias de big data no trabalho médico pode ser medido em números. Ao longo da vida, um indivíduo gera o equivalente a 200 terabytes de informações ligadas à sua saúde. Entretanto, em torno de 90% desses dados se perdem porque não são armazenados, ainda. Estima-se que, se os médicos tivessem acesso ao histórico de todos os pacientes do mundo, seria possível reduzir em 20% a mortalidade global. A precisão nos diagnósticos possibilitaria ainda uma economia de 300 bilhões de dólares ao ano apenas para o sistema de saúde dos Estados Unidos. Esses benefícios levam a uma adoção cada vez mais ampla dessa inovação: a cada ano, aumenta em 20% a digitalização de informações médicas no planeta. Portanto, não está tão longe um futuro no qual não mais 90%, quiçá nem 1%, desse conteúdo será perdido.

Dada a imensidão de estatísticas que podem ser colhidas, como organizá-las e compreendê-las? A resposta está nos softwares de big data. Eles são resultado direto do exponencial barateamento da capacidade de armazenamento dos computadores, acompanhado pela multiplicação do processamento dessas máquinas e pelo avanço da tecnologia de sequenciamento genético. Tudo somado, temos a interpretação automática, mesmo por aparelhos comerciais como smartphones e tablets, de todo o conteúdo compilado pelos profissionais. E haja dados: um único hospital pode acumular 665 terabytes deles ao ano, o equivalente a três vezes todo o catálogo da Biblioteca do Congresso americano, a maior do mundo.

Um dos mais novos e promissores frutos desse caldo tecnológico é o programa Watson Health, próprio para hospitais. Lançado pela IBM em abril de 2015, ele é um refinado produto de inteligência artificial, alimentado pelos potentes servidores da empresa americana, cuja missão é agrupar grande parte dos dados medicinais do planeta para facilitar o trabalho dos médicos. No mês passado, a IBM começou a negociar a instalação do programa em clínicas brasileiras. Como ele vai funcionar? O Watson é alimentado de informações provenientes de laboratórios, hospitais e até mesmo iPhones. Em uma parceria com a Apple, a IBM fez com que seu software tivesse acesso a informações geradas a partir de aplicativos de celular e tablet que medem o estado de saúde de seus usuários. Que tipo de material é coletado? Quantos passos as pessoas dão em um dia, se dormem bem, em que ritmo bate o coração, e muito mais. “Há uns cinco anos começamos a notar quanto essa abordagem da computação, chamada de cognitiva, se tornará chave para a evolução do cuidado médico”, disse a VEJA o oncologista americano Mark Kris, um dos responsáveis pelo projeto do Watson Health. “A ferramenta que criamos é fundamental para a construção de tratamentos individuais, específicos e sob medida, de cada paciente, em qualquer lugar. É o futuro da medicina, começando hoje.”

No consultório, o Watson Health acaba por operar como um Google dos médicos. A tecnologia apresenta subdivisões de acordo com a especialidade do campo da saúde. Uma das mais consultadas é o Watson Oncology, focado na oncologia e desenvolvido em parceria com o prestigiado hospital americano Memorial Sloan Kettering Cancer Center. Durante os últimos cinco anos, médicos abasteceram o Watson — e continuam a fazê-lo — com histórias de casos atuais e antigos de câncer, ensinando assim a inteligência artificial a abordar cada variação da moléstia. Hoje, oncologistas com acesso ao programa consultam esse banco de dados antes de atender um paciente. Nele, é possível inserir o quadro clínico geral de um paciente. A partir daí, a inteligência artificial calcula quais são os métodos que se provaram mais eficientes para o tratamento da enfermidade em questão.

Antes da chegada do Watson Health ao país, hospitais brasileiros já vinham instalando tecnologias similares. Há quatro anos o paulistano Sírio-Libanês investe na criação do que denominou de Biobanco, uma central de servidores com dados de amostras de sangue e tecido e com informações sobre tumores de pacientes. A tecnologia, em teste, ainda é acessada apenas por uma área de pesquisas, na qual quarenta pacientes têm servido de voluntários. “Mas estamos felizes com os resultados e logo implementaremos esse recurso em todo o nosso complexo”, diz o bioquímico Luiz Fernando Reis, responsável pela iniciativa.

Outro exemplo do bom uso do big data na área médica vem do laboratório paulistano Mendelics. Fundada há quatro anos pelo neurologista David Schlesinger, a empresa é especializada em sequenciamento genético, técnica que contribuiu para o desenvolvimento desta era do big data. Por menos de 10 000 reais, em média (há cinco anos, esse valor era mais que o dobro), em apenas um mês de trabalho, o Mendelics analisa o DNA de uma pessoa e identifica as alterações nos genes que podem predispor a algum mal, como a doença de Parkinson, por exemplo.

As vantagens dessas inovações são evidentes. É preciso, porém, atentar também para alguns perigos da novidade. Um deles é a exposição da privacidade das pessoas. Afinal, como saber se um paciente concorda que as informações de sua doença sejam coletadas e jogadas em um banco de dados, expondo sua condição a desconhecidos? Ilustra bem esse nó a existência de uma rede social para profissionais de saúde (o cadastro é gratuito, mas apenas acessível a quem é da área), a Figure 1. Ela funciona como um Instagram com imagens de doenças e adoecidos. Em teoria, é preciso preservar a identidade do paciente ao compartilhar uma imagem — conteúdo que pode ser útil, por exemplo, para um médico pedir orientações a um colega, especialista em uma enfermidade, de um hospital do outro lado do planeta. Entretanto, como tudo na internet, há brechas que acabam por expor as pessoas.

Outro dilema, este talvez ainda mais delicado, é a transformação de qualquer paciente em um especialista, dada a facilidade de coletar dados. No Google, 20% das buscas realizadas são relacionadas a doenças — e muita bobagem, como tratamentos sem fundamentos científicos, aparece quando se faz esse tipo de pesquisa. Com a intenção de reduzir danos, o Google se uniu a hospitais como o paulistano Albert Einstein para sempre apresentar informações corretas quando um usuário faz buscas no site. Desde março, quando alguém procura por uma enfermidade, como a zika, aparece, ao lado dos resultados usuais (normalmente, pouco confiáveis), uma tabela feita por especialistas que descreve a evolução da doença e indica onde procurar ajuda. Como é habitual no mundo da inovação, o problema que surge com a tecnologia acabou sendo resolvido, também, pela própria tecnologia. Há, sim, questões a ser discutidas quando se trata de coleta extensiva de informações individuais. Porém, separar o joio do trigo é algo que já começa a ser feito a partir da análise de dados. O “achismo” morreu.

Por Raquel Beer | Veja

Schlesinger, da Mendelics: sequenciamento genético por 10 000 reais. Antes, custava mais que o dobro (Lailson Santos/Dados que curam)

“Declare o passado, diagnostique o presente e preveja o futuro”, dizia o fisiologista grego Hipócrates, apelidado de o pai da medicina, no século V a.C. Com essa elegante definição do trabalho médico, o pensador indicava a relevância do acúmulo de conhecimento prévio para guiar os tratamentos. Ao receber um paciente, o profissional de saúde precisa, antes de tudo, relacionar os sintomas relatados a outros quadros similares para realizar o exame, prescrever medicamentos e prever qual será a eficiência da terapia recomendada. Até muito recentemente, porém, antes do desenvolvimento de exames de laboratório complexos e conclusivos, os doutores tinham de confiar apenas na memória de um enfermo para desenhar um caminho de cura.

Deu-se agora uma espetacular guinada com o avanço da era digital, da inteligência alimentada pelos algoritmos e do big data — termo que descreve a possibilidade de organizar e consultar, de forma automática, montantes colossais de dados em qualquer área do conhecimento humano.

No século XXI, médicos dependem cada vez menos do próprio conhecimento, ou do que relatam os pacientes, para “declarar o passado, diagnosticar o presente e prever o futuro”. Bastam alguns cliques no computador para ter acesso a quase toda informação. Está acabando o tempo em que clínicos de pronto-socorro podem se contentar em dizer aos doentes, genericamente: “É uma virose”.

O impacto das novas tecnologias de big data no trabalho médico pode ser medido em números. Ao longo da vida, um indivíduo gera o equivalente a 200 terabytes de informações ligadas à sua saúde. Entretanto, em torno de 90% desses dados se perdem porque não são armazenados, ainda. Estima-se que, se os médicos tivessem acesso ao histórico de todos os pacientes do mundo, seria possível reduzir em 20% a mortalidade global. A precisão nos diagnósticos possibilitaria ainda uma economia de 300 bilhões de dólares ao ano apenas para o sistema de saúde dos Estados Unidos. Esses benefícios levam a uma adoção cada vez mais ampla dessa inovação: a cada ano, aumenta em 20% a digitalização de informações médicas no planeta. Portanto, não está tão longe um futuro no qual não mais 90%, quiçá nem 1%, desse conteúdo será perdido.

Dada a imensidão de estatísticas que podem ser colhidas, como organizá-las e compreendê-las? A resposta está nos softwares de big data. Eles são resultado direto do exponencial barateamento da capacidade de armazenamento dos computadores, acompanhado pela multiplicação do processamento dessas máquinas e pelo avanço da tecnologia de sequenciamento genético. Tudo somado, temos a interpretação automática, mesmo por aparelhos comerciais como smartphones e tablets, de todo o conteúdo compilado pelos profissionais. E haja dados: um único hospital pode acumular 665 terabytes deles ao ano, o equivalente a três vezes todo o catálogo da Biblioteca do Congresso americano, a maior do mundo.

Um dos mais novos e promissores frutos desse caldo tecnológico é o programa Watson Health, próprio para hospitais. Lançado pela IBM em abril de 2015, ele é um refinado produto de inteligência artificial, alimentado pelos potentes servidores da empresa americana, cuja missão é agrupar grande parte dos dados medicinais do planeta para facilitar o trabalho dos médicos. No mês passado, a IBM começou a negociar a instalação do programa em clínicas brasileiras. Como ele vai funcionar? O Watson é alimentado de informações provenientes de laboratórios, hospitais e até mesmo iPhones. Em uma parceria com a Apple, a IBM fez com que seu software tivesse acesso a informações geradas a partir de aplicativos de celular e tablet que medem o estado de saúde de seus usuários. Que tipo de material é coletado? Quantos passos as pessoas dão em um dia, se dormem bem, em que ritmo bate o coração, e muito mais. “Há uns cinco anos começamos a notar quanto essa abordagem da computação, chamada de cognitiva, se tornará chave para a evolução do cuidado médico”, disse a VEJA o oncologista americano Mark Kris, um dos responsáveis pelo projeto do Watson Health. “A ferramenta que criamos é fundamental para a construção de tratamentos individuais, específicos e sob medida, de cada paciente, em qualquer lugar. É o futuro da medicina, começando hoje.”

No consultório, o Watson Health acaba por operar como um Google dos médicos. A tecnologia apresenta subdivisões de acordo com a especialidade do campo da saúde. Uma das mais consultadas é o Watson Oncology, focado na oncologia e desenvolvido em parceria com o prestigiado hospital americano Memorial Sloan Kettering Cancer Center. Durante os últimos cinco anos, médicos abasteceram o Watson — e continuam a fazê-lo — com histórias de casos atuais e antigos de câncer, ensinando assim a inteligência artificial a abordar cada variação da moléstia. Hoje, oncologistas com acesso ao programa consultam esse banco de dados antes de atender um paciente. Nele, é possível inserir o quadro clínico geral de um paciente. A partir daí, a inteligência artificial calcula quais são os métodos que se provaram mais eficientes para o tratamento da enfermidade em questão.

Antes da chegada do Watson Health ao país, hospitais brasileiros já vinham instalando tecnologias similares. Há quatro anos o paulistano Sírio-Libanês investe na criação do que denominou de Biobanco, uma central de servidores com dados de amostras de sangue e tecido e com informações sobre tumores de pacientes. A tecnologia, em teste, ainda é acessada apenas por uma área de pesquisas, na qual quarenta pacientes têm servido de voluntários. “Mas estamos felizes com os resultados e logo implementaremos esse recurso em todo o nosso complexo”, diz o bioquímico Luiz Fernando Reis, responsável pela iniciativa.

Outro exemplo do bom uso do big data na área médica vem do laboratório paulistano Mendelics. Fundada há quatro anos pelo neurologista David Schlesinger, a empresa é especializada em sequenciamento genético, técnica que contribuiu para o desenvolvimento desta era do big data. Por menos de 10 000 reais, em média (há cinco anos, esse valor era mais que o dobro), em apenas um mês de trabalho, o Mendelics analisa o DNA de uma pessoa e identifica as alterações nos genes que podem predispor a algum mal, como a doença de Parkinson, por exemplo.

As vantagens dessas inovações são evidentes. É preciso, porém, atentar também para alguns perigos da novidade. Um deles é a exposição da privacidade das pessoas. Afinal, como saber se um paciente concorda que as informações de sua doença sejam coletadas e jogadas em um banco de dados, expondo sua condição a desconhecidos? Ilustra bem esse nó a existência de uma rede social para profissionais de saúde (o cadastro é gratuito, mas apenas acessível a quem é da área), a Figure 1. Ela funciona como um Instagram com imagens de doenças e adoecidos. Em teoria, é preciso preservar a identidade do paciente ao compartilhar uma imagem — conteúdo que pode ser útil, por exemplo, para um médico pedir orientações a um colega, especialista em uma enfermidade, de um hospital do outro lado do planeta. Entretanto, como tudo na internet, há brechas que acabam por expor as pessoas.

Outro dilema, este talvez ainda mais delicado, é a transformação de qualquer paciente em um especialista, dada a facilidade de coletar dados. No Google, 20% das buscas realizadas são relacionadas a doenças — e muita bobagem, como tratamentos sem fundamentos científicos, aparece quando se faz esse tipo de pesquisa. Com a intenção de reduzir danos, o Google se uniu a hospitais como o paulistano Albert Einstein para sempre apresentar informações corretas quando um usuário faz buscas no site. Desde março, quando alguém procura por uma enfermidade, como a zika, aparece, ao lado dos resultados usuais (normalmente, pouco confiáveis), uma tabela feita por especialistas que descreve a evolução da doença e indica onde procurar ajuda. Como é habitual no mundo da inovação, o problema que surge com a tecnologia acabou sendo resolvido, também, pela própria tecnologia. Há, sim, questões a ser discutidas quando se trata de coleta extensiva de informações individuais. Porém, separar o joio do trigo é algo que já começa a ser feito a partir da análise de dados. O “achismo” morreu.

terça-feira, 15 de dezembro de 2015

Dados e cultura

por Gilberto Paschoal | Revista e

Ao proporcionar interatividade em escala, a internet se estabeleceu como o grande fenômeno de comunicação contemporâneo, tendo criado novas lógicas de relações sociais e econômicas facilmente exemplificadas pelo aparecimento e disseminação das mídias sociais e de toda estruturação do mercado digital.

Um fato consolidado entre as novidades trazidas na esteira dessas transformações é o enorme volume de informações sobre os usuários captadas em suas interações no ambiente online. Nesse contexto, o conceito de Big Data, que expressa um volume gigantesco de dados disponíveis para análise, se associa ao de Business Intelligence (inteligência de mercado), que consiste na depuração desse amontoado de informações para geração de conhecimentos e insights a respeito de algum tema. Esses mecanismos vêm sendo usados como norteadores da distribuição segmentada de produtos, serviços e mídia, viabilizando novas formas de planejamento estratégico para qualquer tipo de ação - digital ou não.

Suas aplicações no âmbito da cultura ainda se restringem a alguns casos exemplares, mas já trazem questões relevantes sobre a ética da informação no ambiente digital e seu papel no âmbito da criação e da difusão artística. Grandes estúdios de Hollywood têm feito uso de estruturas de Big Data e BI para determinar a melhor época para lançar filmes com características e públicos específicos, bem como para avaliar a participação de determinados artistas em cada projeto pelo prisma de seu impacto mercadológico. Já é sabido que a série House of Cards foi construída com base em análise de dados que refletiam as preferências dos usuários do Netflix, culminando na escolha da temática, atores e diretores com a maior probabilidade de sucesso. Parece ter funcionado.

Outra forma de uso de dados dos usuários, ainda que mais discreta, é a implementação de algoritmos de recomendação de conteúdo por parte das plataformas de distribuição. Por conta do enorme volume de conteúdo, além dos serviços refinados de busca, os algoritmos se prestam a uma espécie de editoria eletrônica baseada em tendências distinguidas a partir de dados de navegações prévias. Seu papel no ambiente online tem se tornado tão importante que serviços de streaming musical como Spotify e Apple Music têm equipes inteiramente dedicadas a esse estudo, de modo que a reação dos usuários às recomendações é monitorada constantemente e ajustes são realizados muitas vezes em tempo real a partir de estatísticas de Big Data. E para além desses usos específicos para recomendações, as grandes empresas de tecnologia investem pesadamente em estruturas de inteligência artificial capazes de tirar conclusões a partir de dados não estruturados. Softwares de análise preditiva já são capazes de triunfar em programas televisivos de perguntas e respostas, tendo também realizado descobertas científicas baseadas na assimilação de grandes volumes de estudos acadêmicos sobre temas diversos.

Num momento em que os bens culturais digitais apresentam índices de produção, veiculação e alcance jamais experimentados, cabe aos gestores e produtores culturais encontrar o papel adequado para os dados do público num contexto que se pretenda democratizante e emancipador. Não se trata, evidentemente, de bisbilhotar a vida de indivíduos ou de terceirizar responsabilidades curatoriais transferindo-as para máquinas e softwares; mas de lidar de forma transparente, crítica e propositiva com ferramentas e informações cruciais para a compreensão dos hábitos e valores culturais contemporâneos.

quarta-feira, 23 de setembro de 2015

Tecnologias como Watson irão substituir humanos em breve?

Esse tipo de capacidade servirá para auxiliar humanos em suas tarefas e na tomada de decisão - que deverá ser mais rápida.

O Watson é um sistema de inteligência artificial que é capaz de realizar pesquisas dentro de um vasto repositório de informações e extrair análises e retornar respostas em segundos.

Muitos podem achar que esse tipo de tecnologia substituirá humanos em um futuro breve - especialmente se você conhecer o Watson como o bot que derrubou humanos no Jeopardy!, programa de perguntas e respostas exibido pelo canal norte-americano CBS.

Mas não é isso que irá acontecer, afirmou o médico John Kelly, responsável por liderar a equipe do Watson na IBM, em uma apresentação no TechCrunch Disrupt, que ocorre essa semana em San Francisco.

Em uma demonstração da capacidade de processamento do Watson, o repórter Alex Wilhelm questionou o computador sobre a exatidão dos dados contidos na Wikipedia, o que ele respondeu depois de alguns segundos que a enciclopédia on-line era uma fonte confiável de informações.

Esse tipo de capacidade estará disponível para desenvolvedores dentro de um ano ou um pouco mais, de acordo com Kelly, e servirá para auxiliar humanos em suas tarefas e na tomada de decisão - que deverá ser mais rápida.

A capacidade do Watson é tamanha que o grande desafio é fazê-lo focar em segmentos específicos para atuar em problemas de diferentes negócios, como estão fazendo com o Watson Saúde e Watson Finance.

"Essa nova tecnologia vai mudar o mundo. Pense sobre a tomada de decisões sem viés ou informações incompletas", disse Kelly.

Fonte: IT Forum

quinta-feira, 6 de agosto de 2015

Algoritmos facilitam classificação automatizada de textos da internet

A representação das relações entre termos em redes permite aprender padrões que não são assimilados em outros tipos de representações (imagem: FAPESP)

Diego Freire | Agência FAPESP - Um conjunto de algoritmos desenvolvidos no Instituto de Ciências Matemáticas e de Computação (ICMC) da Universidade de São Paulo (USP), em São Carlos, permite filtrar, entre grandes quantidades de textos, dados que possibilitam classificá-los de acordo com o teor de seu conteúdo.

Dessa forma, comentários publicados em redes sociais podem ser facilmente identificados como positivos ou negativos e coleções de bibliotecas virtuais podem ser categorizadas de acordo com o gênero literário, temas e outros aspectos específicos de cada obra.

Os algoritmos foram desenvolvidos por Rafael Geraldeli Rossi, responsável pela pesquisa de doutorado Extraindo padrões de coleções de documentos textuais utilizando redes heterogêneas, realizada com o apoio da FAPESP. O trabalho foi premiado na 16th International Conference on Intelligent Text Processing and Computational Linguistics, em abril, no Egito.

“A quantidade de informações à disposição em diferentes plataformas facilmente acessíveis, como a web, é cada vez maior. É preciso que sejam desenvolvidas novas estratégias para filtrá-las de maneira inteligente, sem que dados se percam no processo e garantindo maior precisão na interpretação das informações”, disse Rossi.

Os algoritmos desenvolvidos por Rossi permitem a classificação, considerando não só a incidência de termos específicos em diferentes textos, mas também redes formadas por associações entre termos, o que agiliza o processo e diminui a quantidade de informações que precisam ser fornecidas para “treinar” a máquina.

O trabalho é desenvolvido por meio de aprendizado de máquina, campo da inteligência artificial dedicado ao desenvolvimento de algoritmos e de técnicas que permitem ao computador aperfeiçoar seu desempenho em alguma tarefa, “aprendendo” a partir de exemplos previamente classificados por um usuário ou especialista.

De acordo com Solange Oliveira Rezende, pesquisadora do ICMC e orientadora da pesquisa, a representação de dados em redes possibilita melhorar a organização e classificação de dados considerando poucos exemplos anteriormente classificados.

“A representação das relações entre termos em redes permite aprender padrões que não são assimilados em outros tipos de representações. A partir daí foram desenvolvidos os algoritmos que manipulam essas representações em redes de termos, permitindo fazer análises sobre os diferentes tipos de relações que podem existir entre os termos e adequando o aprendizado de máquina às necessidades do usuário”, explicou.

Para Rezende, os algoritmos desenvolvidos por Rossi simplificam o processo de classificação sem prejudicar sua precisão e minimizando a complexidade computacional.

“O grande diferencial do trabalho é que ele não considera apenas a frequência dos termos nos documentos, que é o mais comum nesse tipo de pesquisa. Leva-se em conta também a relação entre termos para realizar a classificação dos textos.”

O trabalho foi desenvolvido no âmbito da pesquisa Aprendizado de máquina para WebSensors: algoritmos e aplicações, conduzida por Rezende no ICMC também com o apoio da FAPESP.

O objetivo, explicou a pesquisadora, é investigar métodos de aprendizado de máquina para apoiar a construção automática de sensores da Web.

“O desenvolvimento de um websensor depende de especialistas para definição dos parâmetros do sensor, como expressões para busca, filtros e monitoramentos de conteúdo textual da Web, o que torna o processo mais complexo. Os algoritmos de aprendizado de máquina semissupervisionados para classificação de textos, como os desenvolvidos na pesquisa, podem ser utilizados para gerar sensores e monitorar exemplos de interesse do usuário”, disse Rezende.

Segundo a pesquisadora, o estudo busca contribuir ainda com a exploração do potencial da Web como “um grande e poderoso sensor social, permitindo monitorar vários tipos de eventos a partir de textos publicados em portais de notícias e redes sociais, como detecção de epidemias, extração de indicadores políticos e econômicos e análise de sentimentos”.

Os resultados da pesquisa de Rossi, que conta ainda com a colaboração de Alneu de Andrade Lopes, professor do ICMC, podem ser acessados em sites.labic.icmc.usp.br/ragero/cicling_2015.

Diego Freire | Agência FAPESP - Um conjunto de algoritmos desenvolvidos no Instituto de Ciências Matemáticas e de Computação (ICMC) da Universidade de São Paulo (USP), em São Carlos, permite filtrar, entre grandes quantidades de textos, dados que possibilitam classificá-los de acordo com o teor de seu conteúdo.

Dessa forma, comentários publicados em redes sociais podem ser facilmente identificados como positivos ou negativos e coleções de bibliotecas virtuais podem ser categorizadas de acordo com o gênero literário, temas e outros aspectos específicos de cada obra.

Os algoritmos foram desenvolvidos por Rafael Geraldeli Rossi, responsável pela pesquisa de doutorado Extraindo padrões de coleções de documentos textuais utilizando redes heterogêneas, realizada com o apoio da FAPESP. O trabalho foi premiado na 16th International Conference on Intelligent Text Processing and Computational Linguistics, em abril, no Egito.

“A quantidade de informações à disposição em diferentes plataformas facilmente acessíveis, como a web, é cada vez maior. É preciso que sejam desenvolvidas novas estratégias para filtrá-las de maneira inteligente, sem que dados se percam no processo e garantindo maior precisão na interpretação das informações”, disse Rossi.

Os algoritmos desenvolvidos por Rossi permitem a classificação, considerando não só a incidência de termos específicos em diferentes textos, mas também redes formadas por associações entre termos, o que agiliza o processo e diminui a quantidade de informações que precisam ser fornecidas para “treinar” a máquina.

O trabalho é desenvolvido por meio de aprendizado de máquina, campo da inteligência artificial dedicado ao desenvolvimento de algoritmos e de técnicas que permitem ao computador aperfeiçoar seu desempenho em alguma tarefa, “aprendendo” a partir de exemplos previamente classificados por um usuário ou especialista.

De acordo com Solange Oliveira Rezende, pesquisadora do ICMC e orientadora da pesquisa, a representação de dados em redes possibilita melhorar a organização e classificação de dados considerando poucos exemplos anteriormente classificados.

“A representação das relações entre termos em redes permite aprender padrões que não são assimilados em outros tipos de representações. A partir daí foram desenvolvidos os algoritmos que manipulam essas representações em redes de termos, permitindo fazer análises sobre os diferentes tipos de relações que podem existir entre os termos e adequando o aprendizado de máquina às necessidades do usuário”, explicou.

Para Rezende, os algoritmos desenvolvidos por Rossi simplificam o processo de classificação sem prejudicar sua precisão e minimizando a complexidade computacional.

“O grande diferencial do trabalho é que ele não considera apenas a frequência dos termos nos documentos, que é o mais comum nesse tipo de pesquisa. Leva-se em conta também a relação entre termos para realizar a classificação dos textos.”

O trabalho foi desenvolvido no âmbito da pesquisa Aprendizado de máquina para WebSensors: algoritmos e aplicações, conduzida por Rezende no ICMC também com o apoio da FAPESP.

O objetivo, explicou a pesquisadora, é investigar métodos de aprendizado de máquina para apoiar a construção automática de sensores da Web.

“O desenvolvimento de um websensor depende de especialistas para definição dos parâmetros do sensor, como expressões para busca, filtros e monitoramentos de conteúdo textual da Web, o que torna o processo mais complexo. Os algoritmos de aprendizado de máquina semissupervisionados para classificação de textos, como os desenvolvidos na pesquisa, podem ser utilizados para gerar sensores e monitorar exemplos de interesse do usuário”, disse Rezende.

Segundo a pesquisadora, o estudo busca contribuir ainda com a exploração do potencial da Web como “um grande e poderoso sensor social, permitindo monitorar vários tipos de eventos a partir de textos publicados em portais de notícias e redes sociais, como detecção de epidemias, extração de indicadores políticos e econômicos e análise de sentimentos”.

Os resultados da pesquisa de Rossi, que conta ainda com a colaboração de Alneu de Andrade Lopes, professor do ICMC, podem ser acessados em sites.labic.icmc.usp.br/ragero/cicling_2015.

quinta-feira, 14 de maio de 2015

Stephen Hawking: 'Computadores vão superar humanos dentro de 100 anos'

Dentro de 100 anos os computadores terão superado os humanos graças ao desenvolvimento da inteligência artificial. Ao menos essa é a opinião do cosmólogo Stephen Hawking, mundialmente reconhecido como uma das principais autoridades vivas da ciência.

Hawking esteve na Zeitgeist 2015 em Londres, nesta semana, onde falou sobre os problemas que podem surgir devido ao investimento descontrolado na "mente" das máquinas.

"Os computadores superarão os humanos com a IA (inteligência artificial) em algum momento dentro dos próximos 100 anos", disse ele, de acordo com o Techworld. "Nosso futuro é uma corrida entre o crescente poder da tecnologia e a sabedoria com que a usamos."

via Redação Olhar Digital

terça-feira, 23 de dezembro de 2014

Inteligência artificial vai dominar o mundo em 2015 - ao menos, no cinema

Filmes como ‘Vingadores: Era de Ultron’, ‘O Exterminador do Futuro: Gênesis’ e ‘Ex Machina’ trarão robôs sedutores, vingativos e cruéis

Veja

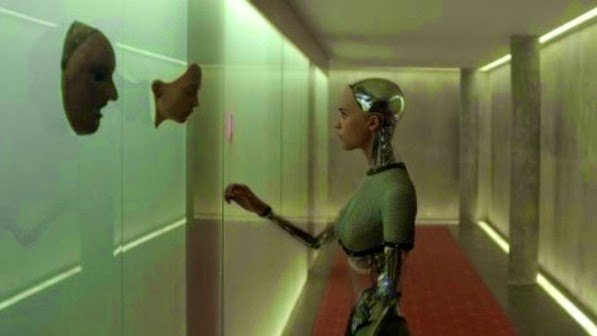

Cena do filme 'Ex Machina', thriller de ficção-científica, que estreia em janeiro de 2015 nos cinemas brasileiros

No início de dezembro, o físico britânico Stephen Hawking disse acreditar que o fim da humanidade poderá ser causado pelo rápido avanço da inteligência artificial. Em uma entrevista à rede britânica BBC, o cientista disse que essa tecnologia pode evoluir rapidamente e superar o homem. Verdade ou não, o tema é fonte farta de inspiração para os cineastas. Em 2015, filmes como Chappie, Vingadores: Era de Ultron, O Exterminador do Futuro: Gênesis e Ex Machina vão explorar as possíveis consequências do dia em que robôs poderão agir por conta própria. As informações são do site da revista americana Entertainment Weekly.

Chappie, que estreia em 16 de abril no Brasil, traz um robô que deveria servir as forças policiais de Johanesburgo, na África do Sul. Entretanto, ao ser reiniciado em uma experiência de Dean (Dev Patel de Quem Quer Ser um Milionário?), um jovem cientista, Chappie começa a ter sentimentos, pensamentos e impulsos humanos. “Ele é um robô que é mais humano do que muitos seres humanos", disse o cineasta e roteirista do longa, Neill Blomkamp (Distrito 9). Dentre as próximas estreias de ficção científica, Chappie é quase um estranho no ninho — os demais filmes trazem robôs maléficos.

Joss Whedon, diretor e roteirista de Vingadores: Era de Ultron, que deve estrear em 30 de abril no Brasil, acredita que a presença da inteligência artificial no cinema pode ser comparada com o que a escritora britânica Mary Shelley fez no romance Frankenstein, sobre um monstro criado pela ciência, em 1818. O longa vai contar com um vilão robótico indestrutível, com inteligência ilimitada. "Nós criamos algo baseado em nossa própria imagem e que gira em torno de nós”, disse. "Eu não lembro de ter visto um filme onde o robô é o ser mais emocionalmente instável do elenco. Ele tem o conhecimento de 3.000 anos de história e é um adolescente mal humorado. Tudo ao mesmo tempo ", disse Whedon.

Já O Exterminador do Futuro: Gênesis, que estreia em 2 de julho de 2015 no Brasil, traz um exército de humanoides que deseja exterminar os humanos da face da Terra. O futuro retratado no longa pode não estar distante, como aponta o cientista Hawking, e foi pensando nisso que o produtor David Ellison fez o filme. "A linha divisória entre o homem e a máquina nunca esteve tão perto de acabar", disse ele.

Nenhum dos dois, porém, apresenta uma máquina tão sexy como a idealizada em

Ex Machina, filme que estreia em 23 de janeiro de 2015 no Brasil. O thriller de ficção-científica mostra Ava, uma robô artificialmente inteligente, criada por Nathan (Oscar Isaac), que seduz e confunde Caleb (Domhnall Gleeson), um jovem programador chamado para testar a misteriosa máquina. "O filme está dizendo: 'Isso é um robô de aparência feminina. Uma máquina muito bonita. Mas ainda assim é uma máquina. E, em seguida, o longa coloca o espectador no lugar do personagem Caleb, que está cada vez mais cego em relação à Ava", disse Alex Garland, roteirista de Extermínio (2002), e que estreia agora como diretor, em

Ex Machina.

Veja

Cena do filme 'Ex Machina', thriller de ficção-científica, que estreia em janeiro de 2015 nos cinemas brasileiros

No início de dezembro, o físico britânico Stephen Hawking disse acreditar que o fim da humanidade poderá ser causado pelo rápido avanço da inteligência artificial. Em uma entrevista à rede britânica BBC, o cientista disse que essa tecnologia pode evoluir rapidamente e superar o homem. Verdade ou não, o tema é fonte farta de inspiração para os cineastas. Em 2015, filmes como Chappie, Vingadores: Era de Ultron, O Exterminador do Futuro: Gênesis e Ex Machina vão explorar as possíveis consequências do dia em que robôs poderão agir por conta própria. As informações são do site da revista americana Entertainment Weekly.

Chappie, que estreia em 16 de abril no Brasil, traz um robô que deveria servir as forças policiais de Johanesburgo, na África do Sul. Entretanto, ao ser reiniciado em uma experiência de Dean (Dev Patel de Quem Quer Ser um Milionário?), um jovem cientista, Chappie começa a ter sentimentos, pensamentos e impulsos humanos. “Ele é um robô que é mais humano do que muitos seres humanos", disse o cineasta e roteirista do longa, Neill Blomkamp (Distrito 9). Dentre as próximas estreias de ficção científica, Chappie é quase um estranho no ninho — os demais filmes trazem robôs maléficos.

Joss Whedon, diretor e roteirista de Vingadores: Era de Ultron, que deve estrear em 30 de abril no Brasil, acredita que a presença da inteligência artificial no cinema pode ser comparada com o que a escritora britânica Mary Shelley fez no romance Frankenstein, sobre um monstro criado pela ciência, em 1818. O longa vai contar com um vilão robótico indestrutível, com inteligência ilimitada. "Nós criamos algo baseado em nossa própria imagem e que gira em torno de nós”, disse. "Eu não lembro de ter visto um filme onde o robô é o ser mais emocionalmente instável do elenco. Ele tem o conhecimento de 3.000 anos de história e é um adolescente mal humorado. Tudo ao mesmo tempo ", disse Whedon.

Já O Exterminador do Futuro: Gênesis, que estreia em 2 de julho de 2015 no Brasil, traz um exército de humanoides que deseja exterminar os humanos da face da Terra. O futuro retratado no longa pode não estar distante, como aponta o cientista Hawking, e foi pensando nisso que o produtor David Ellison fez o filme. "A linha divisória entre o homem e a máquina nunca esteve tão perto de acabar", disse ele.

Nenhum dos dois, porém, apresenta uma máquina tão sexy como a idealizada em

Ex Machina, filme que estreia em 23 de janeiro de 2015 no Brasil. O thriller de ficção-científica mostra Ava, uma robô artificialmente inteligente, criada por Nathan (Oscar Isaac), que seduz e confunde Caleb (Domhnall Gleeson), um jovem programador chamado para testar a misteriosa máquina. "O filme está dizendo: 'Isso é um robô de aparência feminina. Uma máquina muito bonita. Mas ainda assim é uma máquina. E, em seguida, o longa coloca o espectador no lugar do personagem Caleb, que está cada vez mais cego em relação à Ava", disse Alex Garland, roteirista de Extermínio (2002), e que estreia agora como diretor, em

Ex Machina.

segunda-feira, 21 de abril de 2014

Transcendence

O Dr. Will Caster (Johnny Depp) é o mais notável pesquisador no campo da Inteligência Artificial. Ele trabalha no projeto de criação de uma máquina consciente, capaz de combinar a inteligência coletiva de tudo o que existe com todas as possibilidades de emoções humanas. Os experimentos altamente controversos trouxeram fama ao cientista, mas também o transformaram no alvo principal dos extremistas anti-tecnologia, que farão o que for necessário para destruí-lo.

domingo, 23 de fevereiro de 2014

Software com sentimento, tecnologia do filme 'Ela' ainda está distante

Favorito ao Oscar de Melhor Roteiro, longa traz sistema que ri e faz sexo. Interface humanizada presente do filme é 'ensaiada' no Siri e Google Now.

Helton Simões Gomes | Do G1, em São Paulo

Joaquin Phoenix no filme 'Ela' (Foto: Divulgação)

Imagine se tornar tão próximo do sistema operacional de seu computador a ponto de não só virar seu amigo, mas também se ver perdidamente apaixonado por ele. Esse é o enredo do filme "Ela", que estreou dia 14 no Brasil. Apesar de distante, uma realidade como essa já vem sendo saboreada em pílulas pelos consumidores de tecnologia.

No longa, o solitário Theodore Twonbly (Joaquin Phoenix) começa a testar um novo sistema operacional (OS) que até escolhe o próprio nome: Samantha (dublada por Scarlett Johansson). A nova tecnologia chama a atenção do homem, ainda traumatizado pelo término de um casamento, por prometer uma relação mais profunda. Samantha surpreende Twombly por falar com trejeitos humanos e por ser capaz de se solidarizar com ele ou demonstrar preocupação.

Favorito ao Oscar de Melhor Roteiro Original, o filme alimenta a discussão sobre quando programas de computador serão capazes de transmitir sentimentos ou de agir de forma passional a ponto de parecerem seres humanos.

"Na realidade, estamos muito distantes do 'Ela' e da possibilidade de a gente ter um negócio daquele", afirma o professor doutor Marcos Barretto, da Escola Politécnica da Universidade de São Paulo (Poli-USP). "Eu não tenho a menor expectativa de ver isso no meu tempo de vida", pontua o cientista, que mantém pesquisas sobre robôs sociáveis e computação afetiva.

Essa opinião, porém, não é consenso. "Eu posicionaria a Samantha em 2029, quando o salto para um nível humano de inteligência virtual seria razoavelmente crível. Há algumas incongruências, no entanto", escreveu o renomado futurista Ray Kurzweil, conhecido pela teoria da singularidade e que, em 2012, passou a ser diretor de engenharia do Google.

Para o professor doutor Anderson Rocha, do Instituto de Computação da Universidade Estadual de Campinas (Unicamp), um software como a Samantha "tem que ser dividido em partes": uma que compreenda funções de interação mais simples e outra, os sentimentos.

Sem emoção

Algumas das características do OS de "Ela" já estão ao alcance dos dedos de qualquer consumidor, como o reconhecimento de lugares, de face e de voz. "Interfaces de voz com linguagem natural, como Siri e Google Now, começam a ser verdade, mas em um contexto limitado e só numa categoria de problemas que você tem uma pergunta e uma resposta específica", exemplifica Barretto.

Apesar de dizer já ser uma realidade os pedidos feitos ao Siri ou ao Now que localizem o restaurante japonês mais próximo, Barretto afirma que essa é uma das diferenças básicas entre eles e o sistema operacional de "Ela": apesar de obter as respostas, isso não caracteriza uma conversa. "Não tem uma conversa, mas uma interação. É uma série de interações e cada uma é desconexa das anteriores".

Tela de comando do Siri, iniciada quando o usuário segura o botão da parte frontal do iPhone 4S (Foto: Reprodução)

Rocha lista alguns softwares que já conseguem trazer um pouco de "Ela" para o dia a dia, como o Google Goggles (reconhecimento de imagens). "Essas coisas já estão razoavelmente encaminhadas na área de visão computacional e inteligência artificial", diz Rocha. "O desenvolvimento emocional por parte da máquina é o que exigiria um maior exercício de adivinhação. Hoje nós não temos nada ainda".

Outra barreira é a capacidade de os sistemas aprenderem algo para o qual não foram programados. "Você pode programar o computador para um jogo, mas isso passa por um problema central que é como se aprende. Todo o trabalho de aprendizado de máquina que se tem feito é muito restrito", diz.

O exemplo disso é o supercomputador Watson, da IBM, que venceu participantes do programa de TV "Jeopardy" em 2011. A máquina consegue processar uma grande quantidade de informações a ponto de notar nuances no tom de uma mensagem, distinguindo, por exemplo, se "tiger" (de tigre) está se referindo ao jogador de golfe Tiger Woods ou ao animal. Ainda assim, não aprende.

Aprender

Quem tem celulares equipados com o Android, porém, já tem a impressão de que o sistema é capaz de "entender e aprender" informações. Isso porque o Google Now consegue fazer "ilações", como identificar se um lugar é o domicílio do usuário, e até se adiantar a questionamentos, como a que horas é preciso deixar um local para chegar no horário a um compromisso. Todas essas funções, no entanto, são baseadas ou no cruzamento de dados do próprio usuário ou tiradas de serviços do próprio Google, como o Maps, para consulta da situação do trânsito.

Diferentemente do que existe atualmente, o OS de "Ela" é potente o suficiente para compreender emoções e até reagir de forma similar a um ser humano triste, feliz ou entusiasmado. Os especialistas apontam isso como algo que ainda sequer foi arranhado. "A parte da inteligência emocional, na minha visão, é a que está distante em relação às outras coisas. É possível, mas está distante", diz Rocha, da Unicamp.

Ainda assim, por meio de algoritmos (códigos de programação que executam funções determinadas), há programas que conseguem resvalar expressões da sensibilidade humana. Capaz de captar o gosto musical de um usuário, o serviço de música por streaming Spotify, ainda indisponível no Brasil, é um deles. Tanto é que uma das principais funções do site é a sugestão de novas músicas e novos artistas.

No Brasil, há pesquisadores trabalhando na interação homem-máquina. Na USP, Barretto conduz um grupo de pesquisa que desenvolve um robô capaz de ter conversas olho no olho: com um vocabulário com 30 mil expressões, a máquina chamada de Minerva reconhece rostos, move pescoço para acompanhar seu interlocutor, mexe os lábios ao falar e, segundo seus criadores, até identifica emoções. Esse ano, os cientistas melhorarão as estratégias de diálogos do robô. Na Unicamp, o IC desenvolve, entre outros sistemas, um software de reconhecimento facial.

Helton Simões Gomes | Do G1, em São Paulo

Joaquin Phoenix no filme 'Ela' (Foto: Divulgação)